Finding GPT-4’s mistakes with GPT-4

CriticGPT 是一个基于 GPT-4 的模型,它撰写了对 ChatGPT 响应的评论,以帮助人类训练师在 RLHF 期间发现错误

我们训练了一个基于 GPT-4 的模型,称为 CriticGPT,用于捕获 ChatGPT 代码输出中的错误。我们发现,当人们从 CriticGPT 获得帮助来审查 ChatGPT 代码时,他们在 60% 的时间里比没有帮助的人表现得更好。我们正在开始将类似 CriticGPT 的模型集成到我们的 RLHF 标签管道中,为我们的培训师提供明确的 AI 帮助。这是朝着能够评估先进人工智能系统的输出迈出的一步,如果没有更好的工具,人们可能很难对这些结果进行评分。

为 ChatGPT 提供支持的 GPT-4 系列模型通过“人类反馈强化学习”(RLHF) 进行调整,以提供有用和互动。RLHF 的一个关键部分是收集比较,在这些比较中,被称为 AI 训练师的人对不同的 ChatGPT 响应进行评分。

随着我们在推理和模型行为方面的进步,ChatGPT 变得更加准确,它的错误变得更加微妙。这可能会使 AI 训练师在出现不准确时难以发现不准确之处,从而使为 RLHF 提供支持的比较任务变得更加困难。这是 RLHF 的一个基本局限性,并且随着模型逐渐变得比任何可以提供反馈的人更了解模型,它可能会使调整模型变得越来越困难。

为了帮助应对这一挑战,我们训练 CriticGPT 撰写评论,强调 ChatGPT 答案中的不准确之处。

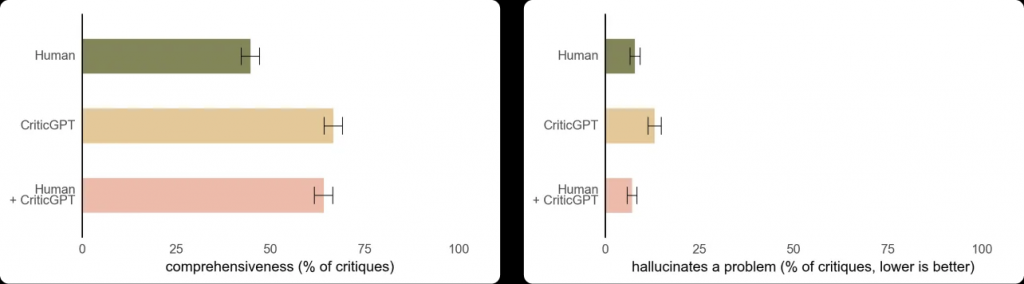

CriticGPT 的建议并不总是正确的,但我们发现,与没有 AI 帮助相比,它们可以帮助培训师通过模型编写的答案发现更多的问题。此外,当人们使用 CriticGPT 时,人工智能增强了他们的技能,从而比人们单独工作时更全面的批评,并且比模型单独工作时更少的幻觉错误。在我们的实验中,第二个随机训练师在超过 60% 的时间里更喜欢来自 Human+CriticGPT 团队的批评,而不是来自无助者的批评。

CriticGPT 帮助培训师写出比没有帮助更全面的评论,同时产生的幻觉比仅来自模型的批评更少。

方法

CriticGPT 也接受了 RLHF 的训练,类似于 ChatGPT。但与 ChatGPT 不同的是,它看到了大量包含错误的输入,然后它不得不对其进行批评。我们要求 AI 训练师手动将这些错误插入到 ChatGPT 编写的代码中,然后编写示例反馈,就好像他们抓住了刚刚插入的错误一样。然后,同一个人比较了对修改后的代码的多个批评,这样他们就可以很容易地判断评论何时抓住了他们插入的错误。在我们的实验中,我们研究了 CriticGPT 是否可以捕获插入的错误和之前培训师捕获的“自然发生的”ChatGPT 错误。我们发现,在 63% 的关于自然发生的错误的案例中,培训师更喜欢 CriticGPT 批评而不是 ChatGPT 批评,部分原因是新批评家产生的“吹毛求疵”(无益的小抱怨)更少,产生幻觉问题的频率也更低。我们还发现,通过对批评奖励模型使用额外的测试时搜索,我们可以生成更长、更全面的批评。这种搜索过程使我们能够平衡在代码中寻找问题的积极程度,并在幻觉和检测到的错误数量之间配置精确召回权衡。这意味着我们可以生成对 RLHF 尽可能有帮助的评论。有关更多详细信息,请参阅我们的研究论文。

局限性

我们在 ChatGPT 的答案上训练了 CriticGPT,这些答案很短。为了监督未来的代理,我们需要开发可以帮助培训师理解长期复杂任务的方法。模特仍然会产生幻觉,有时教练在看到这些幻觉后会犯标签错误。有时,现实世界的错误可能会分散在答案的许多部分。我们的工作重点是可以在一个地方指出的错误,但将来我们也需要解决分散的错误。CriticGPT 只能提供这么多帮助:如果一项任务或响应非常复杂,即使是有模型帮助的专家也可能无法正确评估它。

后续步骤

为了调整日益复杂的人工智能系统,我们需要更好的工具。在我们对 CriticGPT 的研究中,我们发现将 RLHF 应用于 GPT-4 有望帮助人类为 GPT-4 生成更好的 RLHF 数据。我们正计划进一步扩大这项工作的规模并将其付诸实践。