LlamaIndex和LangChain都是用于开发由大型语言模型(LLM)驱动的应用程序的框架,但它们各自侧重于不同的功能和应用场景。

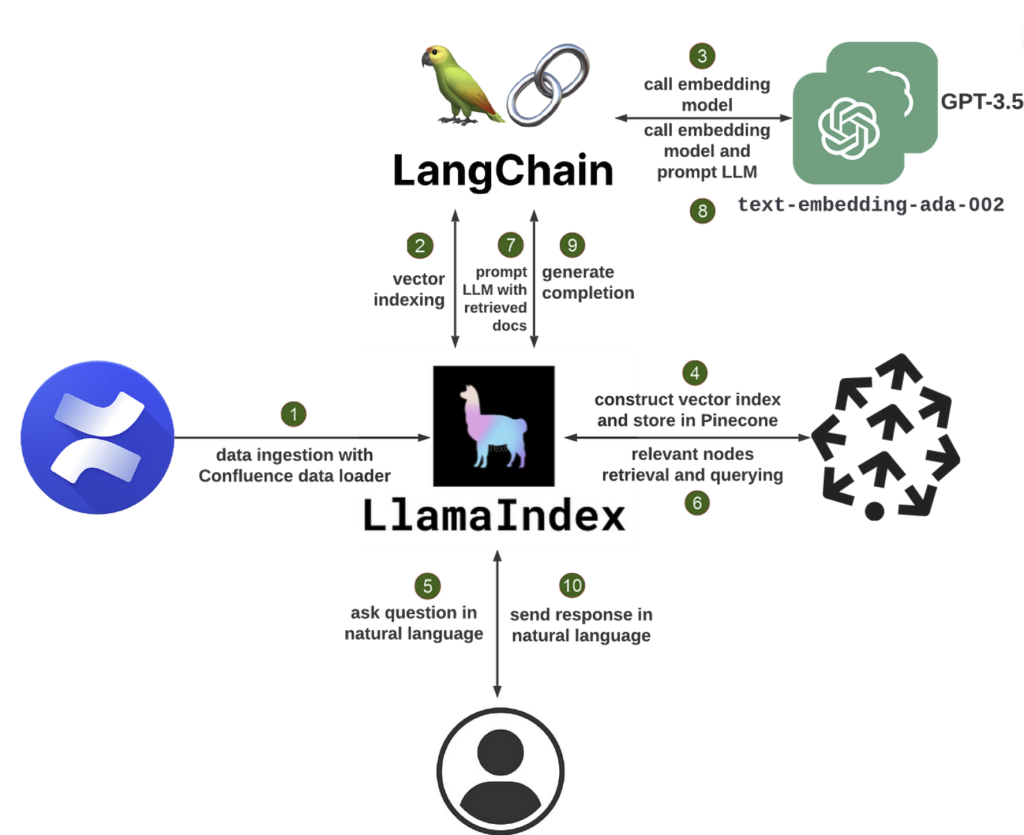

LlamaIndex是一个强大的数据框架,使你能够轻松地将自己的数据连接到LLM。它提供灵活的数据连接器来从多种来源(如API、数据库、PDF等)摄取数据。这些私有数据随后被索引成优化的表示,LLM可以在大规模上访问和解释这些数据,无需重新训练底层模型。LlamaIndex通过检索增强生成(RAG)技术,允许LLM动态地根据查询的语义相似性从向量索引中检索最相关的信息片段,然后生成最终响应 (AI StartUps Info)。

LangChain是一个功能更为全面的框架,它使开发者能够将LLM与各种数据源和服务结合起来。LangChain的核心设计围绕几个关键概念,包括提示、模型、索引和链。LangChain提供了一套标准化的接口和工具,以简化与LLM的交互,包括文本加载器、向量存储索引创建者等组件。LangChain支持多种索引技术,优化了LLM的使用,比如内存中的向量存储和嵌入,还有链,这是一系列调用LLM和其他工具的步骤,输出作为下一步的输入 (AI StartUps Info)。

两者之间的主要区别在于它们的使用场景和灵活性。LlamaIndex特别适合于搜索和检索任务,使其成为深度数据探索的有力工具。相比之下,LangChain提供了更广泛的能力和工具集成,适用于构建更复杂、可适应的LLM应用程序。如果你的主要目标是构建以搜索和检索为中心的应用,LlamaIndex是一个很好的选择。而如果你旨在构建更为复杂、灵活的LLM应用,可能需要自定义查询处理管道、多模式集成,并且需要高度可调节的性能调优,那么LangChain可能更适合你 (Data Science Dojo) (AI Starter)。

更多关于LlamaIndex的信息,你可以参考官方文档以获取更深入的了解 (AI Starter)。而关于LangChain的更多详细信息,也可以在它的官方文档中找到 (AI Starter)。

在自然语言处理 (NLP) 和大型语言模型 ()LLMs 的世界中,开发人员一直在寻求强大的工具来构建尖端应用程序。两个著名的框架已经成为该领域的领跑者:LlamaIndex 和 LangChain。虽然两者都旨在简化与自定义应用程序的LLMs集成,但它们在方法和重点上有所不同。在本文中,我们将深入探讨 LlamaIndex 和 LangChain 之间的主要区别,帮助您在为项目选择框架时做出明智的决定。

第 1 部分 什么是 LlamaIndex?

LlamaIndex 是一个功能强大的数据框架,可让您轻松地将自己的数据连接到 LLMs.它提供灵活的数据连接器,用于从各种来源(如 API、数据库、PDF 等)摄取数据。然后,将此私有数据索引为优化的表示形式,这些LLMs表示形式可以大规模访问和解释,而无需重新训练基础模型。

LlamaIndex 为您的LLMs私人数据提供“记忆”,他们可以利用这些记忆来提供明智的上下文响应。无论您是想在公司的文档上构建聊天机器人、个性化简历分析工具,还是可以回答有关特定知识领域问题的 AI 助手,LlamaIndex 都只需几行代码即可实现。

1.1 LlamaIndex 的工作原理

LlamaIndex 的核心使用一种称为检索增强生成 (RAG) 的技术。典型的RAG系统有两个关键阶段:

- 索引阶段:在索引过程中,您的私有数据会有效地转换为可搜索的向量索引。LlamaIndex 可以处理非结构化文本文档、结构化数据库记录、知识图谱等。数据被转换为数字嵌入,以捕获其语义含义,从而允许以后进行快速相似性搜索

- 查询阶段:当用户查询系统时,根据查询的语义相似性从向量索引中检索最相关的信息块。这些代码段与原始查询一起传递给生成最终响应的LLM通过动态地提取相关上下文,LLM可以输出比仅使用基本知识更高质量、更真实的答案。

LlamaIndex 抽象了构建 RAG 系统的大部分复杂性。它既提供了高级 API,允许您仅从几行代码开始,也提供了用于对数据管道进行细粒度自定义的低级构建基块。

1.2 使用 LlamaIndex 构建简历聊天机器人

首先,安装必要的软件包

|

1 |

pip install llama-index openai pypdf |

接下来,加载您的简历 PDF 并建立索引:

|

1 2 3 4 |

from llama_index import TreeIndex, SimpleDirectoryReader resume = SimpleDirectoryReader("path/to/resume").load_data() index = TreeIndex.from_documents(resume) |

现在,您可以使用自然语言查询索引:

|

1 2 3 |

query_engine = index.as_query_engine() response = query_engine.query("What is the job title?") print(response) |

查询引擎将搜索简历索引并返回最相关的代码片段作为响应,例如“职位名称是软件工程师”。

您还可以进行来回对话:

|

1 2 3 4 5 |

chat_engine = index.as_chat_engine() response = chat_engine.chat("What did this person do in their last role?") print(response) follow_up = chat_engine.chat("What programming languages did they use?") print(follow_up) |

聊天引擎维护对话上下文,允许您提出后续问题,而无需明确重述主题。

若要避免每次都重新生成索引,可以将其保存到磁盘:

|

1 |

index.storage_context.persist() |

稍后再加载:

|

1 2 3 4 |

from llama_index import StorageContext, load_index_from_storage storage_context = StorageContext.from_defaults(persist_dir="./storage") index = load_index_from_storage(storage_context) |

1.3 超越聊天机器人:LlamaIndex 用例

聊天机器人只是您可以使用 LlamaIndex 构建的众多应用程序之一。其他一些例子包括:

- 长文档问答:摄取手册、法律合同或研究论文等文档,并询问有关其内容的问题

- 个性化推荐:在产品目录或内容库上构建索引,并根据用户查询提供建议

- 数据驱动型代理:创建可以访问数据库、API 和其他工具并对其执行操作的 AI 助手,以完成复杂任务

- 知识库构建:从非结构化文本中自动提取实体和关系等结构化数据,构建知识图谱

LlamaIndex 提供了一个灵活的工具包来构建各种LLM支持的应用程序。您可以混合和匹配数据加载器、索引、查询引擎、代理等,为您的用例创建自定义管道。

1.4 LlamaIndex 入门

要开始使用 LlamaIndex 进行构建,请先安装软件包:

|

1 |

pip install llama-index |

您还需要一个 OpenAI API 密钥来访问默认的基础模型。将此设置为环境变量:

import osos.environ[“OPENAI_API_KEY”] = “your_api_key_here”

从那里,您可以开始摄取数据和构建索引!LlamaIndex 文档为常见用例提供了详细的指南和示例。

随着您深入研究,您可以探索 Llama Hub – 社区贡献的数据加载器、索引、查询引擎等的集合。您可以开箱即用地使用这些插件,也可以将其作为您自己的自定义组件的起点。

2. 什么是LangChain?

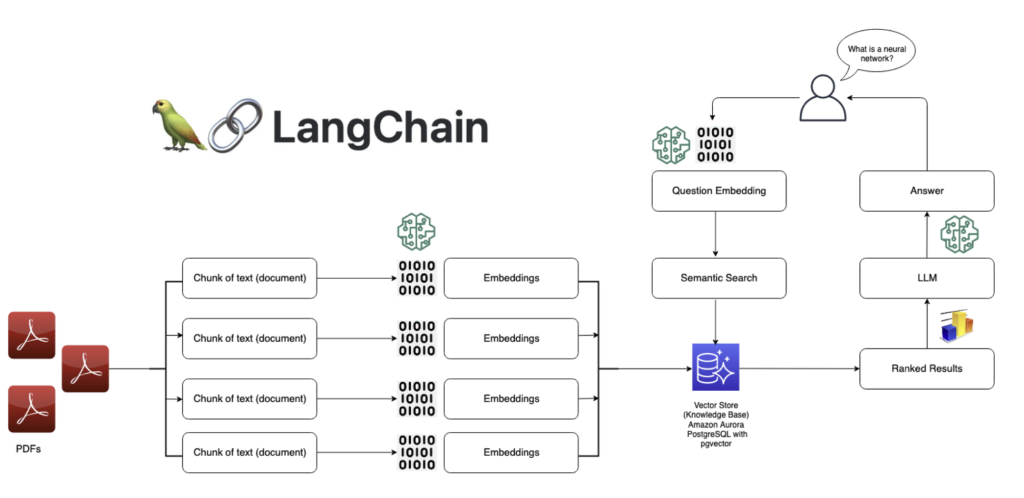

LangChain是一个强大的框架,用于开发由语言模型驱动的应用程序。它使你能够轻松地将自己的数据连接到LLMs并构建数据感知语言模型应用程序。LangChain为链提供了一个标准接口,与其他工具的大量集成,以及为常见应用程序提供的端到端链。

使用 LangChain,您可以从文档、数据库、API 和知识库等各种来源加载数据。然后,在推理期间可以LLMs访问这些私有数据,使他们能够利用该上下文来提供明智的相关响应。无论您是想在公司的文档上构建聊天机器人、数据分析工具,还是与您的数据库和 API 交互的 AI 助手,LangChain 都能实现。

2.1 LangChain如何运作

LangChain的核心是围绕几个关键概念设计的:

- 提示(Prompts):提示是您提供给语言模型以引导其输出的指令。LangChain提供了一个标准接口,用于构建和处理提示。

- 模型(Models):LangChain提供了一个标准接口,用于处理不同的LLMs模型,并提供了一种在它们之间切换的简单方法。它支持 OpenAI 的 GPT-3、Anthropic 的 Claude、Cohere 的模型等模型。

- 索引(Indexes):索引是指文本数据的存储方式,以及语言模型的访问方式。LangChain 提供了几种针对 LLMs优化的索引技术,例如内存向量存储和嵌入。

- 链(Chains):链是对工具和其他工具的调用LLMs序列,一个步骤的输出是下一个步骤的输入。LangChain为链和许多可重用的组件提供了一个标准接口。

- 代理(Agents):代理使用 an LLM 来确定要执行哪些操作以及以什么顺序执行。LangChain提供了一系列可以利用工具完成任务的代理。

使用这些构建基块,您可以创建各种功能强大的语言模型应用程序。LangChain抽象出许多复杂性,使你能够专注于应用程序的高级逻辑。

2.2 使用LangChain构建问答系统

为了说明LangChain的功能,让我们在一组文档上构建一个简单的问答系统。

首先,安装必要的软件包:

|

1 |

pip install langchain openai faiss-cpu |

接下来,加载数据并创建索引:

|

1 2 3 4 5 |

from langchain.document_loaders import TextLoader from langchain.indexes import VectorstoreIndexCreator loader = TextLoader('path/to/document.txt') index = VectorstoreIndexCreator().from_loaders([loader]) |

现在,您可以使用自然语言查询索引:

|

1 2 3 |

query = "What is the main topic of this document?" result = index.query(query) print(result) |

查询将搜索文档并返回最相关的代码片段作为响应。

还可以使用 ConversationalRetrievalChain 与数据进行对话:

|

1 2 3 4 5 6 7 8 9 10 11 12 |

from langchain.chains import ConversationalRetrievalChain from langchain.chat_models import ChatOpenAI model = ChatOpenAI(temperature=0) qa = ConversationalRetrievalChain.from_llm(model,retriever=index.vectorstore.as_retriever()) chat_history = [] while True: query = input("Human: ") result = qa({"question": query, "chat_history": chat_history}) chat_history.append((query, result['answer'])) print(f"Assistant: {result['answer']}") |

这允许来回对话,模型可以从文档中访问相关上下文。

2.3 超越问答:LangChain使用案例

问答只是您可以使用LangChain构建的众多应用程序之一。其他一些例子包括:

- 聊天机器人:创建对话代理,在利用私人数据的同时进行自由形式的对话

- 数据分析:连接 LLMs SQL 数据库、pandas 数据帧和数据可视化库,进行交互式数据探索

- 代理:开发可以使用 Web 浏览器、API 和计算器等工具完成开放式任务的 AI 代理

- 应用生成:根据自然语言规范自动生成整个应用

LangChain提供了一组灵活的组件,可以以无数种方式组合以创建强大的语言模型应用程序。您可以使用内置链和代理,也可以创建自己的自定义管道。

2.4 LangChain入门

要开始使用 LangChain 进行构建,请先安装软件包:

|

1 |

pip install langchain |

您还需要为要使用的模型和工具设置任何必要的 API 密钥。例如,要使用 OpenAI 的模型:

|

1 2 |

import os os.environ["OPENAI_API_KEY"] = "your_api_key_here" |

从那里,您可以开始加载数据、创建链和构建应用程序!LangChain文档为各种用例提供了详细的指南和示例。

随着您深入研究,您可以探索不断发展的LangChain集成和扩展生态系统。该社区已经为无数数据源、工具和框架构建了连接器,使其易于整合LLMs到任何工作流程中。

3. LlamaIndex 与 LangChain 的最佳用例

3.1 LlamaIndex

- 构建搜索引擎和信息检索系统

- 创建知识库和常见问题解答机器人

- 分析和汇总大型文档集合

- 启用对话搜索和问答

3.2 LangChain

- 开发聊天机器人和对话代理

- 构建自定义 NLP 管道和工作流

- 与外部数据源和 API 集成LLMs

- 尝试不同的提示、内存和代理配置

4. LlamaIndex vs LangChain:选择正确的框架

在 LlamaIndex 和 LangChain 之间做出决定时,请考虑以下因素:

- 项目要求:如果您的应用程序主要侧重于搜索和检索,则 LlamaIndex 可能更适合。对于更多样化的 NLP 任务和自定义工作流程,LangChain 提供了更大的灵活性。

- 易用性:LlamaIndex 提供了一个更精简、更适合初学者的界面,而 LangChain 需要更深入地了解 NLP 概念和组件。

- 定制:LangChain的模块化架构允许广泛的定制和微调,而LlamaIndex则提供了一种针对搜索和检索优化的更自以为是的方法。

- 生态系统和社区:这两个框架都有活跃的社区和不断发展的生态系统。考虑浏览他们的文档、示例和社区资源,以衡量可用支持和资源的水平。

5. 结论

LlamaIndex 和 LangChain 是用于构建LLM支持应用程序的强大框架,每个框架都有自己的优势和重点领域。LlamaIndex 在搜索和检索任务方面表现出色,提供简化的数据索引和查询功能。另一方面,LangChain采用模块化方法,为构建各种NLP应用程序提供了一套灵活的工具和组件。

在两者之间进行选择时,请考虑您的项目要求、易用性、定制需求以及各自社区提供的支持。无论您的选择如何,LlamaIndex 和 LangChain 都使开发人员能够利用大型语言模型的潜力并创建创新的 NLP 应用程序。

当您踏上LLM应用程序开发之旅时,请毫不犹豫地探索这两个框架,尝试它们的功能,并利用它们的优势来构建强大且引人入胜的自然语言体验。